什么是 RAG 技术?#

RAG,即检索增强生成 (Retrieval-Augmented Generation),实际上是将知识检索 (Retrieval) 和语言生成 (Generation) 两种技术巧妙地结合在一起。它的核心思想是,在生成回答或文本时,先从海量的文档知识库中检索出与问题最相关的几段文本,然后以此为基础再衍生出连贯自然的回答。就像一个博学多才的人被问到一个问题时,会先在脑海中搜寻相关的知识点,然后再据此组织语言表达出来。

这种 “检索+生成” 的架构,集成了两大技术的优点,既继承了知识库的记忆能力,又借助于语言模型的生成能力。

RAG 的技术优势#

RAG 最突出的优势是 “有据可查”。它会先从知识库中 “查资料”,再根据 “资料” 重新组织语言表达出来,因此生成的文本必然是有事实根据、有出处来源的。这对于对准确性要求较高的应用场景来说更为适用。

而且 RAG 能生成逻辑清晰、结构严谨的文本。知识库为 RAG 提供了天然的 “逻辑框架”,避免了传统生成模型容易出现的 “泛泛而谈”、“散漫驳杂” 的毛病。

相对于纯粹的大规模语言模型,RAG 的训练和使用成本更低。因为大量知识蕴藏在外部文本库中,不需要模型从头去学习。这将大大降低模型训练的难度,缩短训练周期。

RAG 的应用场景#

智能问答#

RAG 最直接的应用,就是构建智能问答系统。传统的问答系统,往往采用基于规则或基于检索的方法,要么只能应对有限的问题模板,要么只能返回现成的答案片段,很难满足用户日益增长的个性化需求。引入 RAG 后,系统不仅能从海量知识库中找到最相关的证据,还能根据具体问题灵活生成回答,做到有的放矢、因人而异。

比如医疗领域,问诊者的病情细节可谓千差万别,RAG 系统就能根据每个人的特定症状,结合医学知识库定制回复。这比过去那种千篇一律的建议,显然更具专业性和针对性。

智能客服#

相比单纯的 FAQ (常见问题) 检索,RAG 驱动下的智能客服,能够处理更加开放和复杂的用户咨询。

比如客户想了解某款新品与老款型号的区别,想查询最近的优惠活动,或是询问售后、退换货等较为专业的问题,RAG 系统都能从企业知识库中快速找到相关说明,再组织成简明扼要的回复。如果遇到 AI 回复不了的问题,还可以想办法自动转接到人工客服。

知识汇总#

信息时代最不缺的就是信息,缺的是对信息的归纳总结。很多时候,我们对某个话题有兴趣,却苦于相关知识散落在各处,缺乏条理化的整合。

这时,RAG 就能派上用场。你只需随手找一个关键词,RAG 就能从指定的文本集合中,迅速检索出所有相关片段,再提炼、融合形成一篇系统性的介绍。相比手工梳理资料,这种方法要高效得多,而且由于囊括了多个来源,汇总后的知识也更加全面客观。

RAG 的局限性和改进方向#

RAG 虽然潜力巨大,但也不是尚方宝剑,仍存在一些局限性:

- RAG 对知识库的质量具有强依赖性。倘若知识库中本身存在错误或者过时的信息,RAG 检索到的片段也就是 “garbage in,garbage out”,即便经过再多加工润色,其本质缺陷也难以弥补。

- RAG 对问题和知识的理解,目前还主要停留在词面匹配的层面,对语义的把握还不够深入。一旦遇到需要常识推理、跨域类比的复杂问题,RAG 可能会力不从心。

- 由于 RAG 本质上仍是深度学习模型,因此也难逃 “黑盒子” 的通病,即很难解释清楚模型给出某个答案的具体依据何在。这对于需要可解释性的应用场景,无疑是个挑战。

改进方向#

对应 RAG 的局限性,未来的研究可朝以下几个方向努力:

- 加强对知识库的质量把控。可借鉴知识图谱、实体链接等技术,对文本库进行去重、消歧、纠错等预处理,并建立严谨的知识溯源机制。

- 引入更多语义理解的技术。比如利用预训练模型来增强文本匹配的语义性,利用常识推理来拓展检索的纵深性等等。

- 改进对话生成的策略。可尝试基于修辞结构理论,对生成内容进行层次划分、关联组织,使之更符合人类表达的逻辑规律。

- 重视对可解释性的研究。除了常见的注意力可视化,还可尝试因果推理、反事实分析等更高阶的技术,让 RAG 的思考过程更 “透明”、更可信。

FastGPT 如何支持您的 Retrieval-Augmented Generation 需求?#

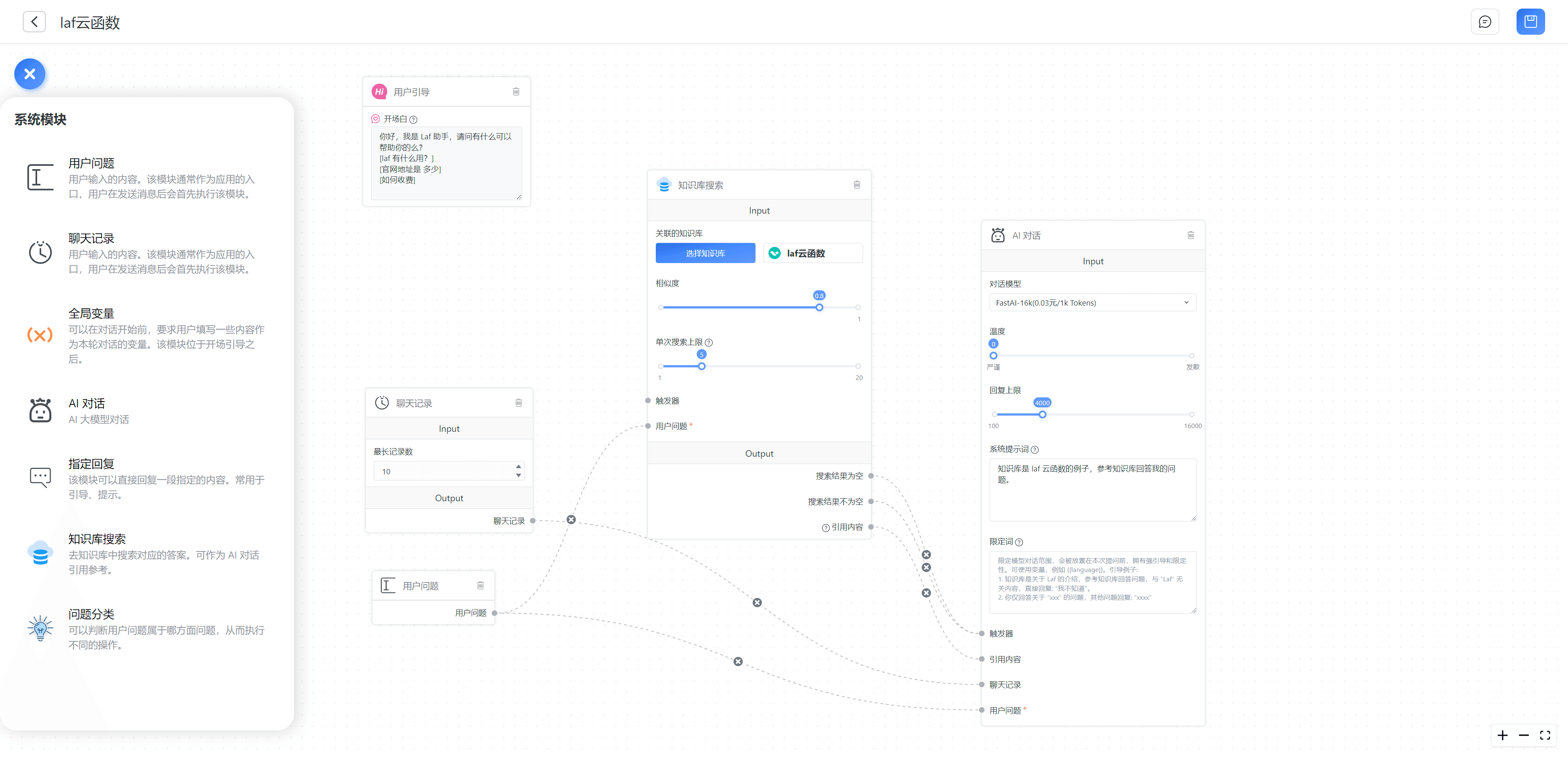

FastGPT 是一个基于 LLM 大语言模型的知识库问答系统,提供开箱即用的数据处理、模型调用等能力。同时可以通过 Flow 可视化进行工作流编排,从而实现复杂的问答场景!

FastGPT 采用直观的可视化界面设计,为各种应用场景提供了丰富实用的功能。通过简洁易懂的操作步骤,可以轻松完成 AI 客服的创建和训练流程。